前面十章爬蟲筆記陸陸續續記錄了一些簡單的Python爬蟲知識,

用來解決簡單的貼吧下載,績點運算自然不在話下。

不過要想批量下載大量的內容,比如知乎的所有的問答,那便顯得游刃不有余了點。

于是乎,爬蟲框架Scrapy就這樣出場了!

Scrapy = Scrach+Python,Scrach這個單詞是抓取的意思,

Scrapy的官網地址:點我點我。

那么下面來簡單的演示一下Scrapy的安裝流程。

具體流程參照://www.jb51.net/article/48607.htm

友情提醒:一定要按照Python的版本下載,要不然安裝的時候會提醒找不到Python。建議大家安裝32位是因為有些版本的必備軟件64位不好找。

1.安裝Python(建議32位)

建議安裝Python2.7.x,3.x貌似還不支持。

安裝完了記得配置環境,將python目錄和python目錄下的Scripts目錄添加到系統環境變量的Path里。

在cmd中輸入python如果出現版本信息說明配置完畢。

2.安裝lxml

lxml是一種使用 Python 編寫的庫,可以迅速、靈活地處理 XML。點擊這里選擇對應的Python版本安裝。

3.安裝setuptools

用來安裝egg文件,點擊這里下載python2.7的對應版本的setuptools。

4.安裝zope.interface

可以使用第三步下載的setuptools來安裝egg文件,現在也有exe版本,點擊這里下載。

5.安裝Twisted

Twisted是用Python實現的基于事件驅動的網絡引擎框架,點擊這里下載。

6.安裝pyOpenSSL

pyOpenSSL是Python的OpenSSL接口,點擊這里下載。

7.安裝win32py

提供win32api,點擊這里下載

8.安裝Scrapy

終于到了激動人心的時候了!安裝了那么多小部件之后終于輪到主角登場。

直接在cmd中輸入easy_install scrapy回車即可。

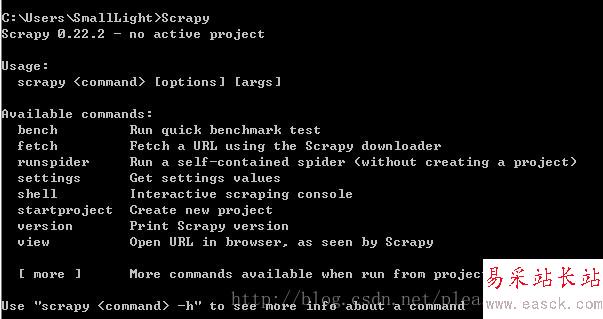

9.檢查安裝

打開一個cmd窗口,在任意位置執行scrapy命令,得到下列頁面,表示環境配置成功。

新聞熱點

疑難解答